AI 시대의 핵심은 반도체입니다. 그리고 그 중심엔 언제나 '그 회사', 엔비디아가 있죠. 왜일까요? 그 이유를 지금부터 풀어봅니다.

안녕하세요, 요즘 AI 뉴스에 빠져 사는 한 사람입니다. 얼마 전 친구들과 점심을 먹다 말고 나온 주제가 바로 "엔비디아"였어요. 'GPU 회사 아냐?' 하던 시절이 엊그제 같은데, 이젠 AI 반도체 하면 무조건 떠오르는 이름이 됐잖아요. 저도 사실 궁금했어요. 도대체 왜 그렇게 다들 엔비디아, 엔비디아 하는지. 오늘은 그 이유를 차근차근, 그리고 흥미롭게 풀어볼게요. 마치 점심시간의 수다처럼 가볍게요!

목차

GPU, AI 시대의 엔진이 되다

예전에는 CPU만으로도 대부분의 컴퓨팅 작업이 가능했어요. 하지만 AI가 등장하고 나서 이야기가 완전히 달라졌죠. AI 모델을 학습시키는 데는 엄청난 양의 연산이 필요한데, 이걸 빠르게 처리할 수 있는 게 바로 GPU예요. 병렬 연산에 특화된 GPU는 딥러닝 모델의 학습 속도를 획기적으로 높여주거든요. 그래서 AI 붐이 일면서 GPU 수요가 폭발적으로 증가했고, 엔비디아가 주목받게 된 거예요.

엔비디아의 비장의 무기, CUDA란?

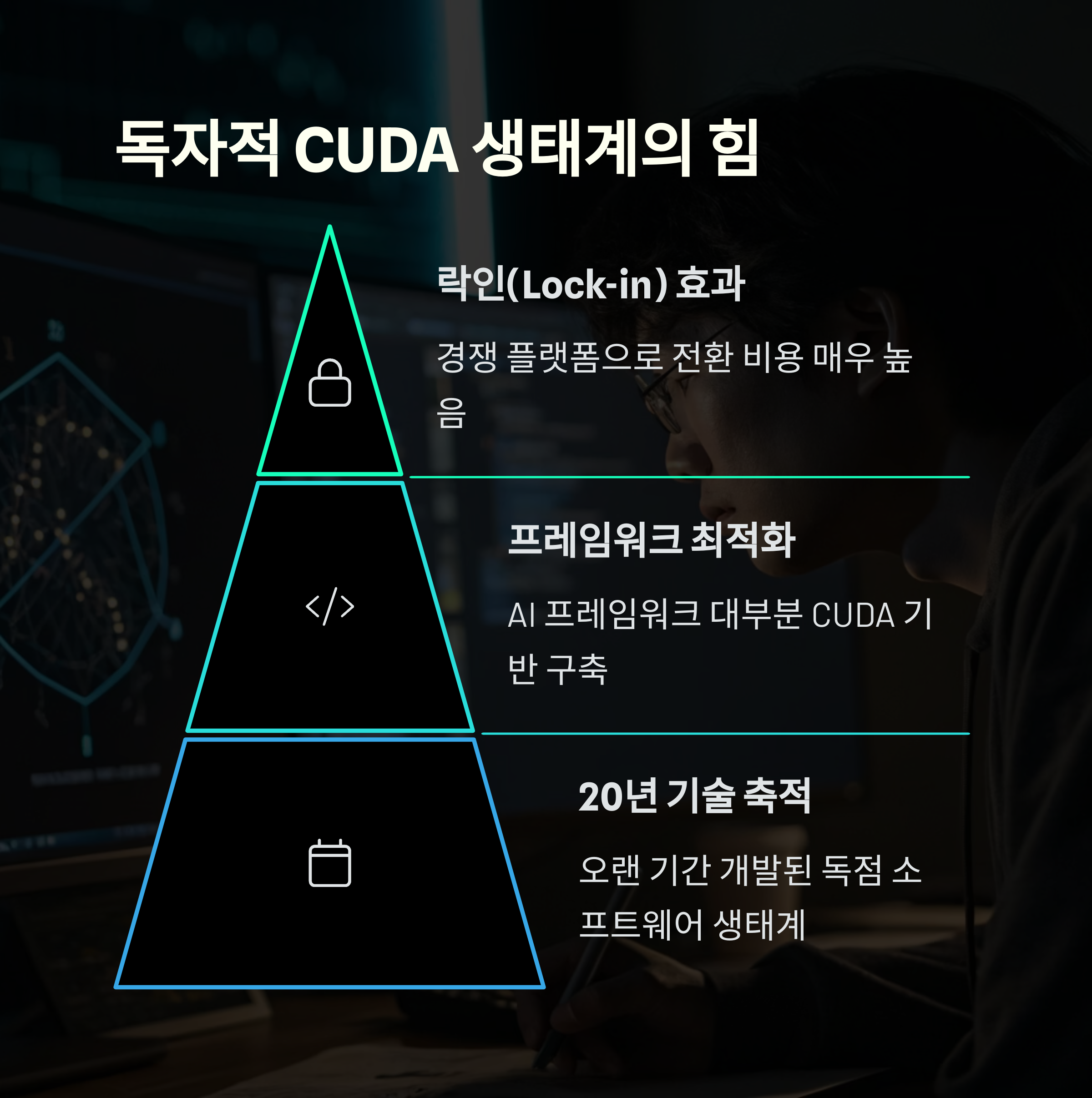

CUDA는 엔비디아가 개발한 GPU 병렬 컴퓨팅 플랫폼이에요. 이 플랫폼 덕분에 개발자들은 GPU를 마치 CPU처럼 쉽게 활용할 수 있게 됐죠. AI 모델 개발자들은 CUDA를 기반으로 딥러닝 라이브러리를 만들 수 있었고, 이게 자연스럽게 엔비디아 GPU 의존도를 높였습니다.

| 항목 | 설명 |

|---|---|

| CUDA | GPU 병렬 연산 프로그래밍 플랫폼 |

| 호환성 | 엔비디아 GPU 전용 |

| 기여 | 딥러닝 생태계 표준화 주도 |

데이터 센터를 장악한 A100과 H100

AI가 클라우드에서 돌아가려면, 결국 그 중심은 데이터 센터잖아요. 엔비디아의 A100, H100 같은 고성능 GPU는 이 데이터 센터의 핵심이 됐어요. 거의 독점 수준으로 사용되고 있고요. 그 이유는 간단해요. 성능이 너무 좋아서요.

- A100: 고성능 학습용, 전 세계 AI 기업들이 채택

- H100: 차세대 트랜스포머 최적화, LLM에 특화

- 병렬성, 메모리, 에너지 효율 모두 최고 수준

개발자 생태계를 지배하는 플랫폼 전략

엔비디아가 AI 반도체 시장을 장악하게 된 또 다른 이유는 바로 '개발자 생태계'예요. 단순히 하드웨어만 잘 만든다고 되는 게 아니잖아요. 개발자들이 쉽게 접근하고, 사용할 수 있는 환경이 필수죠. 엔비디아는 CUDA를 중심으로 TensorRT, cuDNN, Triton Inference Server 같은 툴킷을 제공하면서 개발자들을 꽉 잡았어요. 오픈소스 생태계와도 적극 연계하면서 자연스럽게 시장을 잠식해왔죠.

경쟁사와의 기술 격차, 얼마나 클까?

AMD, 인텔, 심지어 구글, 아마존 같은 빅테크도 AI 반도체 시장에 뛰어들었어요. 하지만 솔직히 말하면, 아직은 엔비디아 따라가기 벅찬 상황이죠. 특히 소프트웨어 호환성과 툴체인에서 큰 차이가 납니다. 아래 비교표를 보면 그 차이가 더 분명해져요.

| 업체 | 주력 제품 | AI 생태계 |

|---|---|---|

| 엔비디아 | H100, A100 | CUDA 기반 독보적 플랫폼 |

| AMD | MI300 시리즈 | 상대적으로 미성숙 |

| 구글 | TPU | 구글 전용 생태계 |

AI 미래와 함께 가는 엔비디아

AI는 이제 막 시작이에요. 자율주행, 헬스케어, 금융, 제조 등 거의 모든 산업에서 AI가 중심이 되고 있죠. 엔비디아는 이 흐름 속에서 하드웨어 그 이상으로 진화하고 있어요. 단순히 칩을 파는 게 아니라, AI 인프라 전체를 설계하는 수준입니다.

- Omniverse: 3D 가상 시뮬레이션 플랫폼

- DGX 서버: AI 슈퍼컴퓨팅 인프라

- AI Foundry: LLM 학습 서비스

맞습니다. 원래는 게임용 그래픽카드로 유명했죠. 하지만 AI 시대가 도래하면서 GPU가 AI 학습의 핵심으로 자리 잡았고, 엔비디아는 이 흐름을 빠르게 캐치했습니다.

CUDA는 GPU를 병렬로 활용할 수 있게 해주는 엔비디아의 독자적 프로그래밍 환경입니다. 쉽게 말해, GPU를 더 똑똑하게 쓰는 도구죠.

A100은 범용 AI 학습용으로, H100은 초대형 언어 모델이나 고난이도 AI 계산에 더 특화돼 있어요. H100이 최신 버전이라고 보면 됩니다.

기술적으로는 가능하지만, 대부분의 딥러닝 프레임워크가 엔비디아 CUDA 기반으로 최적화돼 있어 효율이 많이 떨어져요. 그래서 다들 엔비디아를 쓰는 거예요.

H100은 대형 AI 모델을 돌리는 데 필수예요. 수요가 너무 많고 공급은 제한적이다 보니, 마치 'AI 시대의 금'처럼 여겨지고 있어요.

현재 생태계 기반으로 보면 단기간 내에 뒤집기 어려워 보입니다. 다만, 구글, 아마존 등 빅테크의 반격도 만만치 않아요. 지켜볼 필요가 있어요.

AI 반도체 시장의 핵심 플레이어로 엔비디아가 군림하는 데는 단순히 성능 때문만은 아니었습니다. GPU 기술력, 독자 플랫폼, 개발자 생태계까지 모든 걸 갖춘 그들의 전략은 정말 치밀했죠. 이제는 단순한 반도체 회사가 아니라 AI 시대의 인프라 기업이 되어가고 있는 모습이 인상적입니다. 여러분은 어떻게 보시나요? 댓글로 여러분의 생각도 공유해 주세요!